Vantaggi e sfide nel futuro militare

A livello globale, gli investimenti governativi nell’intelligenza artificiale stanno rapidamente aumentando, diventando una componente rilevante anche nei budget militari. Un esempio tangibile è rappresentato dal Pentagono, che ha presentato al congresso una richiesta di budget di 3 miliardi di dollari destinato allo sviluppo di sistemi intelligenti che mirano a migliorare il processo decisionale e potenziare le piattaforme dei sistemi a guida autonoma. L’avanzamento tecnologico dell’intelligenza artificiale consente lo sviluppo di sistemi più complessi rispetto a decenni fa, aprendo così numerose opportunità che se non regolamentate possono dar vita a ciò che viene definito la “weaponization dell’IA”, un fenomeno in cui l’intelligenza artificiale viene impiegata come un’arma. L’impiego dell’intelligenza artificiale nel contesto militare può risultare estremamente vantaggioso per prendere decisioni cruciali in tempi brevi e minimizzare le perdite umane in situazioni di conflitto. Ciò si traduce, ad esempio, nella creazione di robot per lo sminamento di aree pericolose o di veicoli a guida autonoma per ottimizzare la logistica.

Tuttavia, va considerato che l’IA potrebbe altresì essere utilizzata a fini malevoli, aumentando il numero di vittime attraverso sistemi a guida autonoma, minacciando la sicurezza nazionale con la cyberwarfare e influenzando la sfera cognitiva. L’utilizzo dell’IA come arma presenta una problematica anche dal punto di vista giuridico, in quanto non si conforma al tradizionale diritto internazionale e non rispecchia i cosiddetti “principi umani”. Di conseguenza, le regole che si applicano alle operazioni militari convenzionali non sono direttamente applicabili a tali sistemi, che sfuggono così a sanzioni e attribuzioni. Questa situazione lascia attualmente molte questioni irrisolte e apre il dibattito su come affrontare efficacemente questa sfida emergente. La seguente panoramica mira quindi a fornire una visione allargata sui vantaggi dell’utilizzo dell’IA nel campo militare condensata da una visione critica sulle problematiche nell’adozione di tali sistemi. Un’applicazione di successo sono i Warfare Systems, sistemi di guerra come sensori, supporti alla navigazione, supporto aereo, sorveglianza e tanti altri che possono oggi essere supportati dall’intelligenza artificiale per ottimizzarne i processi e ridurre l’impatto della componente umana. Questo migliorerebbe tutti quegli interventi umani riguardanti la manutenzione e permetterebbe IA militari di operare su altri programmi.

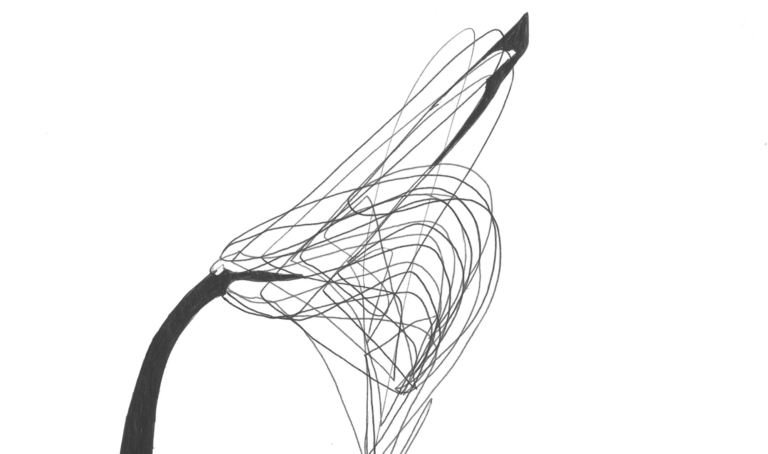

Lo stesso si può dire sugli sciami di droni, una delle ultime frontiere dell’applicazione dell’IA in campo militare. Il sistema consiste in diversi droni autonomi interconnessi, e quando uno di essi riceve un’informazione, può trasmetterla agli altri, operando proprio come uno sciame di api. Analogamente alle api che condividono informazioni benefiche per il loro alveare, i droni possono comunicare dettagli come distanza, direzione, altitudine di un bersaglio e segnalare eventuali pericoli. Altra applicazione fondamentale che si collega a quanto appena detto è il processo decisionale strategico dove le informazioni sono la parte essenziale per prendere decisioni accurate. Qui l’IA può raccogliere ed elaborare dati da numerose fonti diverse per aiutare in scelte strategiche , in situazioni di stress elevato, fornendo possibili soluzioni al decisore in base IA diversi scenari. In virtù dell’ingente mole di informazioni con cui oggi gli analisti militari entrano in contatto, l’intelligenza artificiale può essere impiegata per filtrare i dati e le informazioni più preziose. Questo si rivela fondamentale per gli analisti per fare threat intelligence e raggruppare più informazioni da vari dataset. Inoltre, una IA ben addestrata può anche eliminare informazioni superflue e imprecise, ottimizzando il processo di ricerca.

Altro settore di enorme importanza nel campo militare sono le simulazioni. Le simulazioni in campo militare vengono ormai usate da molto tempo, e impiegate insieme alle nuove tecnologie emergenti, come il Metaverso, forniscono un valido strumento alle forze armate durante periodi di addestramento. Questo genere di IA applicata a sistemi che simulano la realtà offrono un vantaggio perché in grado di simularla eliminando il pericolo. Queste realtà virtuali possono aiutare i soldati a capire come maneggiare le armi, a prendere decisioni in situazioni stressanti e collaborare con i compagni di squadra. Non solo la simulazione basata sull’intelligenza artificiale può addestrare i soldati, ma può personalizzare i programmi di addestramento, nonché effettuare valutazioni eque al fine di apportare future modifiche IA programmi.

La simulazione del combattimento può anche far risparmiare tempo e denaro perché è più efficiente in termini logistici. Proprio la logistica è un’altra componente essenziale delle forze armate e anche qui l’intelligenza artificiale può giocare un ruolo primario. Non soltanto è possibile creare veicoli che in autonomia trasportino munizioni, merci, armamenti e/o truppe, ma può anche identificare in anticipo le necessità delle forze armate al fine di aumentare l’efficienza delle loro prestazioni. Questo abbasserebbe i costi, gli input umani e soprattutto se utilizzata in scenari di guerra, ridurrebbe il pericolo di morte, grazie ad assistenza ed evacuazione autonomi.

La Sicurezza Informatica è un’altra applicazione fondamentale che fino a poco tempo fa ha visto troppa poca attenzione ed è ad oggi uno dei temi più caldi del settore con una considerazione crescente anche da parte delle industrie della difesa. L’IA in questo settore può rivelarsi fondamentale contro l’avvelenamento dei dati, una pratica che può essere messa in atto da attori come disinformazione digitale e che può avvenire in qualsiasi momento. L’avvelenamento consiste nell’addestrare una IA con dati che provochino il malfunzionamento di un’altra IA, portandola così in errore. In campo Cyber, l’IA può essere usata per migliorare i tassi di rilevamento delle minacce informatiche utilizzando indicatori di compromissione già in possesso. In tal senso va considerato che l’impiego dell’intelligenza artificiale nel campo militare presenta diverse sfaccettature che la rendono potenzialmente rischiosa, soprattutto quando utilizzata da attori con intenti non strettamente difensivi. Mentre i sistemi manuali e non connessi in rete offrono una certa sicurezza contro interferenze esterne, la stessa garanzia non si applica IA sistemi basati su intelligenza artificiale connessi alla rete.

La crescente minaccia cibernetica impone l’adozione di sistemi di ultima generazione, ma ciò comporta la necessità di implementare contromisure robuste per resistere a intrusioni avversarie. In un contesto militare, l’utilizzo di sistemi basati su l’IA richiede un elevato grado di sicurezza prima del loro impiego sul campo per evitare eventi incontrollati. Un esempio eloquente di questa vulnerabilità emerge nei droni di ricognizione controllati a distanza, che, se esposti a un attacco cibernetico, potrebbero cadere sotto il controllo di agenti malevoli, diventando armi contro le stesse forze che li impiegano. Nella cyberwarfare, dove la manipolazione delle informazioni è cruciale, la resistenza alle tattiche avverse diventa critica. I sistemi di intelligenza artificiale in questo contesto devono dimostrare robustezza, ovvero la capacità di rilevare e mitigare informazioni non veritiere prima che possano diffondersi, evitando così di influenzare i processi decisionali. Per incrementare la robustezza, è essenziale rendere il modello dietro questi sistemi interpretabile e spiegabile.

Molti sistemi di IA rimangono ancora “black-box”, con una mancanza di trasparenza nel processo decisionale che rende difficile comprendere il motivo di un certo output. Questa trasparenza è cruciale nell’ambito militare, dove la capacità di attribuire responsabilità in caso di errori o comportamenti indesiderati è fondamentale. La spiegabilità diventa quindi una priorità, soprattutto in scenari critici, come il caso di un sistema che identifica erroneamente un’area civile come obiettivo militare, con conseguenze drammatiche, come visto di recente con il sistema Gospel, utilizzato da Israele per bombardare Gaza. La comprensione del perché il sistema prende una decisione specifica diventa cruciale per evitare errori fatali e stabilire responsabilità in caso di incidenti.

Un altro aspetto critico è l’eliminazione di bias nei dati di addestramento. L’utilizzo di modelli di intelligenza artificiale può portare a decisioni discriminatorie se i dati di addestramento riflettono distorsioni nella rappresentatività del campione. In un contesto militare, decisioni basate su modelli con bias possono avere gravi conseguenze, influenzando la vita e la sicurezza delle persone. Sorge quindi un interrogativo cruciale sull’adozione dell’Intelligenza Artificiale nel settore militare: avanzare verso il futuro o restare ancorati al passato? Intraprendere l’innovazione comporta rischi, ma le potenze mondiali comprendono che il progresso tecnologico è inestricabilmente legato alla forza di un paese, tanto quanto la sua potenza militare. In questo scenario, la combinazione di avanzamenti tecnologici e capacità militari determinerà chi realmente dominerà nel prossimo futuro. Ciò solleva inevitabili interrogativi riguardo al rispetto del diritto internazionale e dei principi umani in un mondo sempre più governato dall’IA, dell’effettivo beneficio per l’intera umanità e di come l’innovazione tecnologica sia guidata da valori di etica e trasparenza. In questo contesto, rimane da vedere se, nel prossimo futuro, l’umanità sarà in grado di governare e utilizzare diligentemente questa intelligenza. Come affermava Albert Einstein, “l’umanità avrà la sorte che saprà meritarsi”.