Uno dei principali motivi che ci spingono a sviluppare tecnologie e sistemi di Intelligenza Artificiale è che abbiamo bisogno di prendere decisioni migliori, più rapide e a costo più basso, mentre, d’altro canto, la complessità delle situazioni nelle quali dobbiamo agire cresce costantemente, fino a superare la nostra capacità di comprendere e controllare tutte le variabili in gioco.

Da questo punto di vista, è chiaro infatti che l’enorme capacità computazionale e di memoria dei sistemi informatici moderni consente loro di analizzare e tenere in considerazione molti più dati di quanto possa fare un essere umano; eppure, questo non significa di per sé che le decisioni o le raccomandazioni di un sistema automatico possano essere migliori delle nostre. Fino a che punto possiamo delegare le nostre scelte all’IA?

Cosa dice la legge

Dal punto di vista normativo, una risposta chiara è offerta dall’AI Act, la legge europea che a breve regolerà la produzione e l’utilizzo dei sistemi di IA nell’UE. Il capitolo 14 stabilisce che «i sistemi di IA ad alto rischio [ossia quelli usati per decisioni che coinvolgono interessi e diritti fondamentali dei cittadini] sono progettati e sviluppati, anche con strumenti di interfaccia uomo-macchina adeguati, in modo tale da poter essere efficacemente supervisionati da persone fisiche durante il periodo in cui sono in uso». E, perché questa supervisione possa essere efficace, è necessario che tali sistemi siano «sviluppati e utilizzati in modo da consentire un’adeguata tracciabilità e spiegabilità». In altre parole, il supervisore umano che utilizza o presiede al funzionamento di un sistema di IA deve poter interpretare i risultati prodotti dal sistema e deve poterli spiegare agli interessati (ad esempio, a coloro a cui si applicano le decisioni adottate con l’assistenza dell’IA).

La supervisione e la spiegabilità, in sostanza, vanno a braccetto, perché per poter esercitare la supervisione è necessario poter capire come mai il sistema abbia prodotto uno specifico risultato e se quel risultato possa essere per qualche motivo errato o distorto.

Il problema tecnico

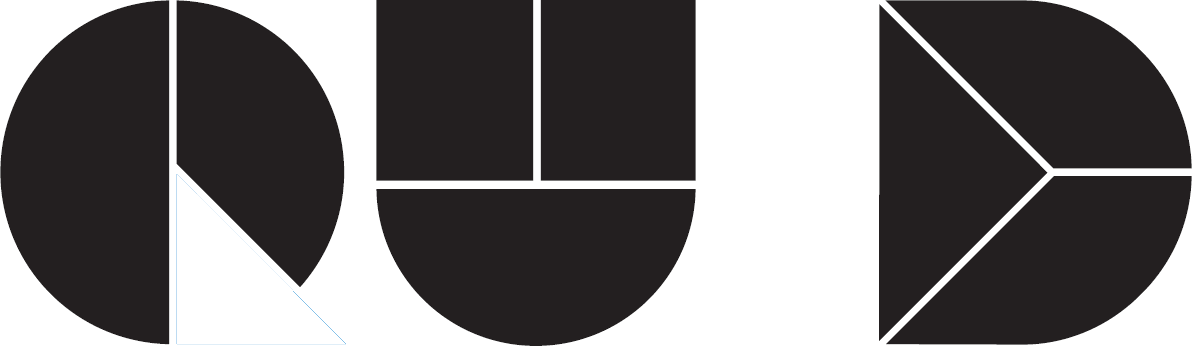

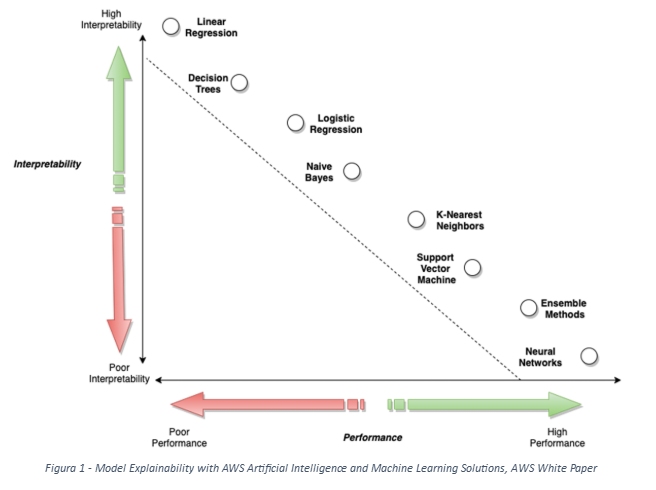

Il problema è che non tutte le tecnologie di IA consentono di realizzare sistemi interpretabili come, a rigore, vorrebbe la legge: alcune di quelle più efficaci e utilizzate, al contrario, agiscono come delle black box, il cui funzionamento interno e in particolare le motivazioni per cui producono i loro risultati non sono noti neanche agli sviluppatori. La relazione inversa tra interpretabilità ed efficacia è rappresentata nella Figura 1, tratta da un documento pubblicato da Amazon.

La soluzione

Per consentire agli utilizzatori e agli altri soggetti umani di comprendere almeno in parte la logica alla base delle risposte dei sistemi di IA, è stato aperto un apposito ambito di ricerca, detto della Explainable AI (XAI), che ha essenzialmente come obiettivo appunto sviluppare tecniche che, applicate ai sistemi black box, forniscano indicazioni sui razionali dei risultati che essi producono. Tra le informazioni che possono essere ricavate in questo modo, ad esempio, c’è l’indicazione di quale o quali dati del problema esaminato abbiano avuto il maggior peso nelle valutazioni del sistema di IA; questo consente spesso di riconoscere la plausibilità di queste valutazioni, perché è chiaro che, ad esempio, un sistema destinato alla selezione di candidati neolaureati per un colloquio di assunzione che assegni il massimo dell’importanza nelle sue decisioni al voto di laurea del candidato appare “ragionevole”, mentre uno che gli attribuisse alcun peso avrebbe molte probabilità di fornire risultati errati.

I problemi aperti

Va comunque tenuto presente che le informazioni ottenibili grazie alle tecniche di XAI sono comunque parziali e indicative, e non possono rendere pienamente interpretabili sistemi originariamente black box; può essere comunque necessario valutare il migliore trade-off tra interpretabilità ed efficacia, a seconda del tipo di applicazione che di caso in caso si considera.

Un altro tema che sicuramente dovremo considerare nel prossimo futuro è la possibilità che i sistemi di IA, in ambiti specifici, raggiungano prestazioni molto superiori a quelle umane; in questo caso, è evidente che tanto la prescrizione di interpretabilità quanto quella di supervisione umana rischieranno di diventare inefficaci, perché un essere umano potrà non essere in grado di capire se una data valutazione di un sistema di IA possa essere giusta o sbagliata, neanche con l’ausilio di elementi di interpretabilità. Già oggi, ad esempio, nel settore della sanità si stanno sperimentando sistemi automatici di analisi di esami radiologici in grado di riconoscere segnali precoci di una futura patologia invisibili all’occhio umano (v. riferimento in bibliografia); è chiaro che in casi simili è difficile pensare che il responso del sistema di IA possa essere “confutato” da una verifica di un radiologo umano.

Bibliografia

Chan K et al., Inflammatory risk and cardiovascular events in patients without obstructive coronary artery disease: the ORFAN multicentre, longitudinal cohort study, The Lancet, Volume 403, Issue 10444, p2606-2618 – June 15, 2024